AG-Blog | AI ready – or not? Deutschlands Start in die Daten- und KI-Revolution

In ihrer ersten Sitzung für dieses Jahr hat sich die AG Datendemokratie mit der Frage beschäftigt, ob Unternehmen, die öffentliche Verwaltung und Politik in Deutschland bereit sind für die neuen technologischen Möglichkeiten, die sich durch künstliche Intelligenz (KI) ergeben.

Berlin. Der Nachrichtenstrom über neue, bahnbrechende KI-Technologien reißt nicht ab. Unternehmen und Verwaltungen stehen vor der Frage, ob und wie sie diese neuen technischen Möglichkeiten für sich nutzen sollen. Was braucht es, um KI-Usecases in der eigenen Organisation einzuführen? Sind deutsche Unternehmen, die öffentliche Verwaltung und politische Institutionen dafür gewappnet? Inwiefern können Offene Daten sinnvolle Grundlage für Automatisierung und Machine-Learning-Anwendungen sein? Mit dieser Perspektive startete die AG Datendemokratie in das Jahr 2024 und lud verschiedene Expert*innen aus der Praxis zur Sitzung in die aconium Akademie in Berlin ein

Künstliche Intelligenz im Bundesumweltministerium

Dr. Mark Azzam, CDO im Bundesministerium für Umwelt und Verbraucherschutz (BMUV), beleuchtete für die AG-Mitglieder, wie in einer obersten Bundesbehörde der Einsatz von KI-Systemen pilotiert und umgesetzt wird – und zwar anhand von tatsächlichen Usecases aus dem BMUV. Zu den Aufgaben eines Ministeriums zählen Entwürfe von Politiken und Strategien, die Bereitstellung von Informationen, Aufsicht und Kontrolle sowie Gesetzes- und Verordnungsentwürfe. Azzam betonte die starke interne und externe Zusammenarbeit der Ministerien sowie die Wichtigkeit von Kommunikation und Transparenz.

Was macht also ein Ministerium? In einem komplexen System, auf einer breiten Datengrundlage und unter Berücksichtigung aller relevanten Informationen Erkenntnisse generieren, möglichst viele Schlüsse daraus ziehen und diese vermitteln.

Jede Entscheidung, die von den entsprechenden Referaten oder Stellen vorbereitet wird, setze einen langen Recherche- und Analyseprozess voraus, der die personellen Ressourcen stark beanspruche. Daher gelte es, die Mitarbeitenden der Ministerien bei gerade diesen Aufgaben langfristig durch KI-Systeme zu entlasten bzw. einzelne Arbeitsschritte sogar vollständig an sie outzusourcen. Ein großes Problem bei der Umsetzung dieses Vorhaben zeige sich in der Wirkungsweise der gängigen KI-Anwendungen, die meist auf Large Language Models (LLM) beruhen. Diese seien zwar extrem kompetent in der massenhaften Datenverarbeitung und Semantik, jedoch nicht sonderlich stark in tatsächlicher Wissensgenerierung. „Symbolische KI“, die anhand logischer Regeln und symbolischer Darstellungen Probleme lösen und Entscheidungen treffen könne, sei diesbezüglich vielversprechender. Diese Form von KI müsse aber noch weiterentwickelt werden, bevor sie tatsächlich zum Einsatz kommen könne.

Azzam unterstrich an dieser Stelle die Notwendigkeit der Datenlabore in den Ministerien. Sie sollen gewährleisten, dass die richtigen Daten und Informationen den richtigen Personen zur richtigen Zeit bedarfsgerecht aufbereitet zur Verfügung stehen. Dazu stelle das Datenlabor digitale Lösungen bereit, welche die Ablage, Verknüpfung, Bereitstellung, Auswertung und Darstellung relevanter, administrativer umwelt- und naturschutzfachlicher Daten und Informationen ermöglichen. Hier könnten potentielle KI-Systeme aufsetzen.

Chatbots und Prototypen

Dann ging es in die Praxis: Azzam stellte den AG-Mitgliedern einige KI-gestützte Prototypen aus dem BMUV vor.

- Ein interaktives Sprachdienst-Wörterbuch für die Übersetzung von deutschsprachigen Dokumenten in Fremdsprachen machte den Anfang. Über eine Suchmaske können einzelne Begriffe in der entsprechenden Sprache nachgeschlagen werden – das Tool ist dabei auf die juristische Sprache und behördliche Begrifflichkeiten spezialisiert.

- Eine weitere KI-Anwendung, die aufwandsintensive Arbeitsschritte erleichtern soll, betrifft die interministerielle Kommunikation. In einem Dokumentenportal können vorliegende Dokumente wie Eckpunktpapiere hochgeladen werden. Die Anwendung „liest“ diese und sucht anschließend die relevanten Referate und Abteilungen heraus, damit diesen die Dokumente zur Kenntnis zugesendet werden können.

- Den meisten wird der Name ChatGPT im Kontext der künstlichen Intelligenz mittlerweile ein Begriff sein. Der eigene, interne Chatbot-Prototyp Chat-BMUV funktioniert vergleichbar, aber datensicher: Über ein internes System können Mitarbeitende des BMUV auf die Anwendung zugreifen, sodass sensible Daten geschützt bleiben. Das System basiert auf den Open-Source-Chatbot Mixtral 8x7B.

Das Brotbacken beginnt mit dem Bestellen der Felder. Es braucht Geduld, bis es Brot gibt, aber Ungeduld mit Blick auf die Aussaat.

So beantwortete Azzam die Ausgangsfrage, ob das BMUV „AI ready“ sei oder nicht. Es sei wichtig, die Grundlagen wie die IT-Infrastruktur, die Daten-Governance und das Datenmanagement, die interne Daten- und Entwickler*innen-Kompetenz sowie die Datenkultur und -offenheit ministerienübergreifend anzugehen. Azzam ist zuversichtlich hinsichtlich des Nutzens KI-gestützter Systeme als Arbeitsentlastung, sieht aber Handlungsbedarf bei der Vorbereitung zur Arbeit mit neuen Technologien und der Überbrückung der Zeit, bis ausgereifte Anwendungen zur Verfügung stehen. Gleichzeitig sei es wichtig, zunächst einmal die Grundlagen entsprechend umzusetzen, bevor komplexere Aufgaben wie die Kernaufgaben der Ministerien in Angriff genommen werden können.

Implementierung von KI-Usecases – Erfahrungen von McKinsey und Quantum Black

Als nächstes erfuhren die Teilnehmenden von Thomas Weber und Luca Flora, Partner und Associate Partner bei McKinsey, sowie Nina Sophia Berger, Data Scientist bei Quantum Black, mehr über die praktischen Erfahrungen der McKinsey Digital Labs: Wie lässt sich Künstliche Intelligenz in Prozesse implementieren? Weber und Flora gaben einen Überblick über die Anwendungsfelder von generativer KI im öffentlichen Sektor. Die beiden sprachen dabei über das Nutzungspotenzial der vier zentralen Anwendungsfelder von generativer KI, die sie aus ihrer Erfahrung wie folgt definierten:

- Nutzer*innen-Interaktion, wie z. B. Chatbots, die Anliegen ganz oder teilumfänglich bearbeiten können (Nutzungspotenzial >60 %)

- Synthese von Inhalten, z. B. die Zusammenfassung und Extraktion von Erkenntnissen aus verschiedenen Datenquellen (Nutzungspotenzial ~40 %)

- Generierung von Inhalten, die Erzeugung von neuen Inhalten (Bild, Ton, Schrift), z. B. Entwürfe für Entscheidungsvorlagen oder Stellungnahmen (Nutzungspotenzial >10x)

- Coding/Programmieren, Erstellung von Code z. B. zur schnellen Reaktion auf potenzielle Cyber-Attacken (Nutzungspotenzial >55 %)

Außerdem erläuterten sie, wie die Nutzung (generativer) KI langfristig als stabile Fähigkeit in der Organisation verankert werden könne. Der Schlüssel sei die modulare Erweiterung von KI-Fähigkeiten in einer Organisation „in die Breite“ und „in die Tiefe“. Dabei müsse beim Ersteren von einzelnen Anwendungsfällen hin zu skalierten, generativen KI-Fähigkeiten gedacht werden und beim Letzterem ausgehend vom Proof of Concept hin zum etablierten Werkzeug.

Die Skalierung von (generativer) KI über erste Anwendungsfälle hinaus erfordere dabei den Aufbau der Fähigkeiten in sechs Dimensionen:

- Strategische Roadmap: Wie kann die KI-Strategie mit den allgemeinen (technologischen) Zielen der Organisation in Einklang gebracht werden? Wie kann die Transformation so gestaltet werden, dass ein größtmöglicher Mehrwert entsteht?

- Talent: Welche Talente und Fähigkeiten benötigen wir? Was müssen wir tun, um diese zu gewinnen?

- Operating Model: Wie organisieren wir uns und unsere Teams, um unsere KI-Strategie zu verwirklichen?

- Technologie: Wie können wir einen skalierbaren Tech-Stack und Infrastruktur einrichten, und wie greifen wir am besten auf Modelle zu?

- Daten: Relevanz der Qualität der Datensätze (inhaltlich, sprachlich, etc.): KI-Module basieren immer auf zur Verfügung stehenden Daten.

- Einführung und Skalierung

Wie können die Technologien in Zukunft von öffentlichen Unternehmen genutzt werden?

Nina Sophia Berger erläuterte darauf aufbauend, dass sich die einzelnen KI-Anwendungen immer stärker spezialisieren und an die einzelnen Bedürfnisse der Unternehmen anpassen werden.

Es gibt noch keine generelle Lösung. Deshalb werden häufig zunächst kurzfristige oder mittelfristige Lösungen gebraucht.

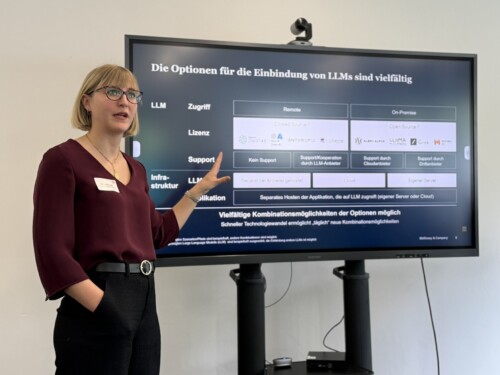

So könne beispielsweise ein interner Server eine gute Möglichkeit darstellen, überhaupt solche Technologien nutzen zu können, bis „sicherere“ Modelle zur allgemeinen Verfügung stehen. Die Optionen für die Einbindung von KI-Anwendungen (wie LLMs) seien jedoch bereits jetzt vielfältig. Unternehmen sollten sich vor der Einbindung unter anderem die Frage nach dem Zugriff stellen: In Fachkreisen werde hier von „take, make or shape“ gesprochen – also der Entscheidung, entweder ein bereits existierendes Modell zu verwenden (take), ein eigenes Modell zu entwickeln (make) oder ein existierendes Modell zu verändern und den eigenen Bedürfnissen anzupassen (shape). Dabei sei auch die Frage nach der vorhandenen Infrastruktur wichtig, beispielsweise ob überhaupt qualifiziertes Personal vorhanden sei, um eine solche Anwendung zu pflegen. Auch bei Punkten wie Lizenz, Support oder Applikation stehe den Unternehmen eine Vielzahl an Optionen offen. Bereits jetzt seien vielfältige Kombinationsmöglichkeiten aus den verschiedenen Optionen möglich.

Das GovTech Campus Lernmodul: KI-Regulierung und -Governance

Um das qualifizierte Personal ging es dann auch bei Rico Komenda, Senior Security Consultant bei adesso, der den Teilnehmenden einen Einblick in das neuste Lernmodul des GovTech Campus Deutschland gab. Der GovTech Campus Deutschland ist ein Innovations-, Entwicklungs- und Lernraum mit dem Ziel, Deutschland zum Vorreiter bei der Entwicklung und Anwendung digitaler Technologien und Lösungen für den öffentlichen Sektor zu machen. Er vernetzt Bund, Länder und Kommunen mit innovativen Akteur*innen der Techszene, der Zivilgesellschaft, der Open-Source-Community und der angewandten Forschung. In diesem Rahmen stellen sie unter anderem Lernangebote für Mitarbeitende der öffentlichen Verwaltung zur Verfügung. Und um ein solches ging es bei der AG-Sitzung: nämlich das zur KI-Regulierung und Governance.

Was ist mit KI-Governance überhaupt gemeint?

Grundsätzlich kann KI-Governance als ein Satz von Richtlinien und Praktiken verstanden werden, der die zielgerichtete und veranwortungsvolle Entwicklung und Nutzung von KI-Systemen in einer Organisation sicherstellen soll.

Komenda sprach in diesem Zusammenhang von vier Leitprinzipien, auf die eine KI-Governance basieren könne:

- Nützlichkeit: um sicherzustellen, dass KI-Systeme aus einem bestimmten Grund entwickelt/genutzt werden und einen konkreten Wert für die Organisation bieten

- Compliance: um sicherzustellen, dass KI-Systeme innerhalb der gesetzlichen Rahmen operieren und nicht zu rechtlichen Schwierigkeiten führen

- Robustheit: um sicherzustellen, das KI-Systeme zuverlässig und sicher sind

- Ethik: um sicherzustellen, dass KI-Systeme fair sind und keine Schäden für die Menschenrechte verursachen

Dabei gehe es jedoch nicht um reine Regulierung; es gebe auch wichtige soziale und wirtschaftliche Aspekte, aus denen gesellschaftliche Herausforderungen hervor gehen. Dazu zählen beispielsweise mangelndes Verständnis und Fachwissen. Auch die globalen und grenzübergreifenden Auswirkungen dürften nicht außer Acht gelassen werden.

Wie kann eine solche KI-Governance aussehen?

Komenda stellte dann die gängigen Frameworks (ISO 42001:2023, AIGA, AI Risk Management Framework) für die Umsetzung einer solchen KI-Governance vor – so wie sie auch die teilnehmenden Fachkräfte bei seinem Lernangebot im GovTech Campus kennen lernen. Diese sollen Organisationen dabei helfen, sicherzustellen, dass die Risiken eines KI-Systems angemessen eingeordnet und behandelt werden. Je nach der Herangehensweise sei die Applikation unterschiedlicher Standards sinnvoll. Auch hier sei die Entscheidung abhängig davon, ob Organisationen eine eigene Anwendung entwickeln oder eine bestehende Anwendung übernehmen oder anpassen. Komenda betonte, dass es zurzeit noch kein Framework gebe, dass allein vollständig konform zum neuen EU AI-Act sei. Jedoch bleibe aufgrund der rasanten technologischen Entwicklung auch keine Zeit zum Abwarten, weshalb auch er für kurz- und mittelfristige Lösungen plädierte. Die Entwicklung von KI-Richtlinien werde in der Zukunft ohnehin immer stärker von den einzelnen Anwendungsbedürfnissen der Organisationen abhängig sein.

Im Bereich der KI-Governance sieht Komenda zwar noch einigen Handlungsbedarf, gleichzeitig hat er Vertrauen in eine erfolgreiche, gemeinschaftliche Umsetzung. Das Vorantreiben dieser sei besonders wichtig, um die technologische und wirtschaftliche Autonomie Deutschlands voranzutreiben und zu schützen:

Es ist wichtig einheitliche Standards festzulegen, aber man muss auch das Rad nicht neu erfinden. Wir müssen in Deutschland mehr Expert*innen auf diesem Gebiet ausbilden, die dann das benötigte Fachwissen in die Organisationen tragen.